Core Lecture 1 Intro to MDPs and Exact Solution Methods -- Pieter Abbeel

reinforcement learining is interesting!

一、概述和Markov Decision Process

Markov Decision

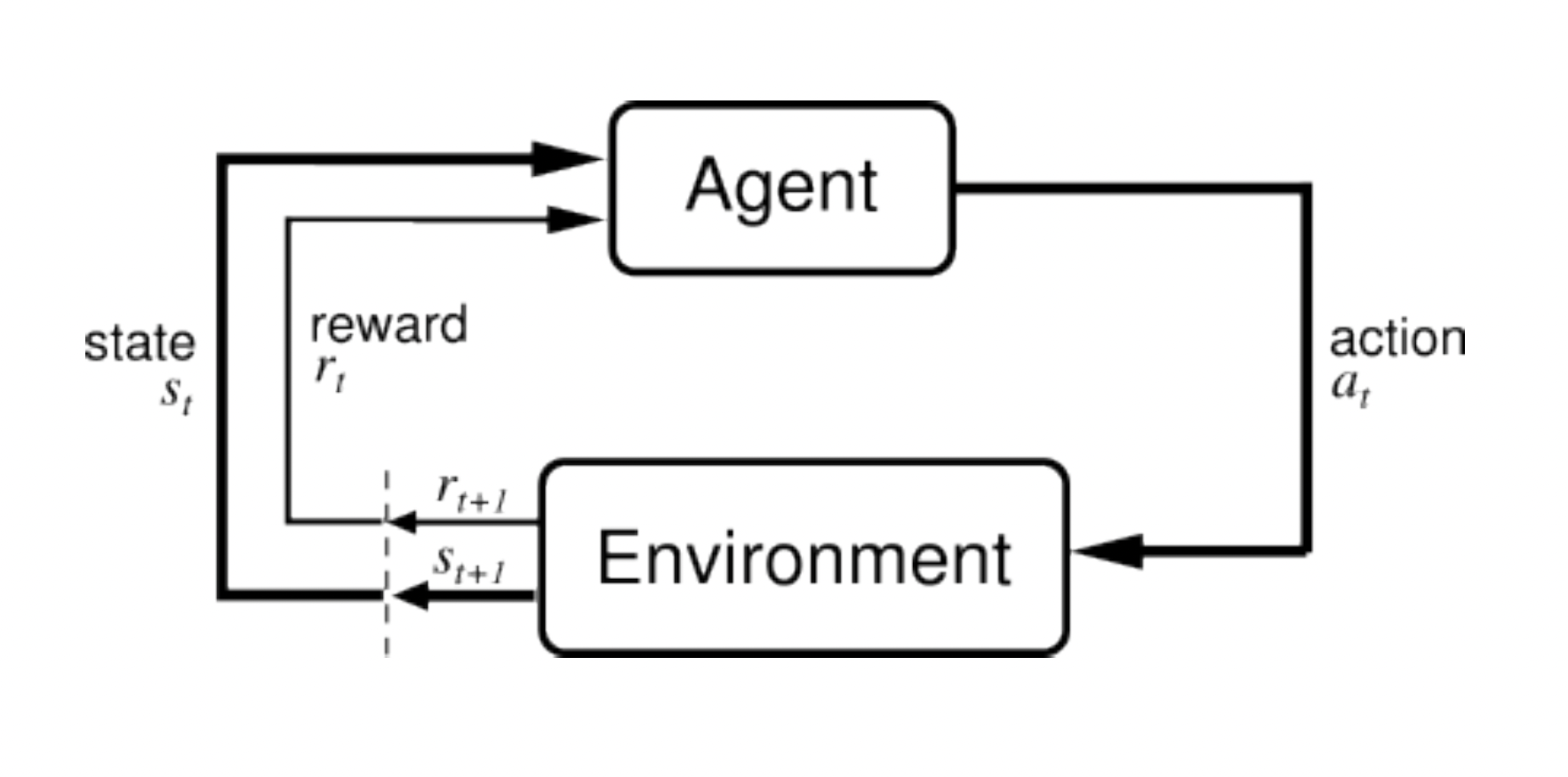

Process(马尔科夫决策过程)指的是一种随机过程,是强化学习最重要的理论基础之一。简单的说,马尔科夫决策过程中最重要的对象有两个,一个是Agent,另一个是Environment。在强化学习的过程中,Agent和Environment不断进行互动,信息相互流动,互动的结果提供给Agent作为其进行下一步行动(action)的依据,同时互动的经验也会被纳入到学习的过程中,完成强化学习这一过程。简单的说,在时间t时,Agent处于某个当前状态(state)

Markov Decision

Process(马尔科夫决策过程)指的是一种随机过程,是强化学习最重要的理论基础之一。简单的说,马尔科夫决策过程中最重要的对象有两个,一个是Agent,另一个是Environment。在强化学习的过程中,Agent和Environment不断进行互动,信息相互流动,互动的结果提供给Agent作为其进行下一步行动(action)的依据,同时互动的经验也会被纳入到学习的过程中,完成强化学习这一过程。简单的说,在时间t时,Agent处于某个当前状态(state)

好像有点扯远了,具体对Markov Decision

Process下一个定义的话是这样的,Markov过程是一个典型的序列决策过程,下一个状态的产生只和当前的状态有关,与历史状态没有直接关系,但是当前的状态s实际上是和历史状态相关联的,但是我们在进行决策的时候并不需要考虑这一点,这就是Markov的特点。下面结合课程中所给的

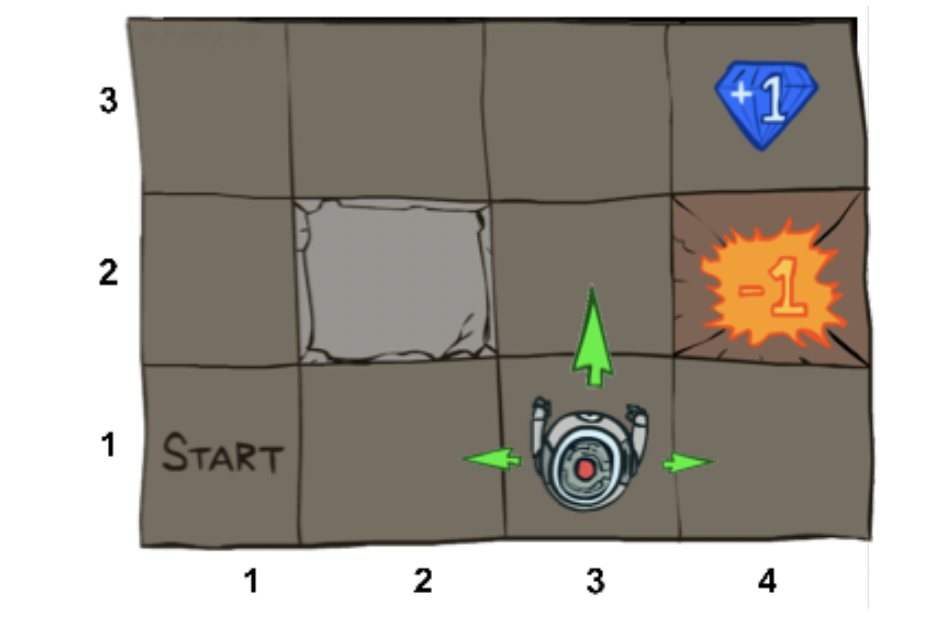

Gridworld小游戏如左图所示,机器人(Agent)处在一个4*3的棋盘(Environment)中,棋盘上有12个方格,每个方格就是一个状态,机器人在不同位置的不同方格中就是处于不同的状态,从一个方格移动到另一个方格就是从一个状态转移到另一个状态。注意到棋盘上有一些障碍物,这就是不能达到的状态,另外有标注"+1"的宝石和标注"-1"的爆炸,这些表示离开这个状态的时候可以获得的reward(注意!在移动过程中某个状态奖励获得的时刻是在进行了action离开这个状态的时候才能够获得),其他没有标注数字的格子状态的reward都是零。

Gridworld小游戏如左图所示,机器人(Agent)处在一个4*3的棋盘(Environment)中,棋盘上有12个方格,每个方格就是一个状态,机器人在不同位置的不同方格中就是处于不同的状态,从一个方格移动到另一个方格就是从一个状态转移到另一个状态。注意到棋盘上有一些障碍物,这就是不能达到的状态,另外有标注"+1"的宝石和标注"-1"的爆炸,这些表示离开这个状态的时候可以获得的reward(注意!在移动过程中某个状态奖励获得的时刻是在进行了action离开这个状态的时候才能够获得),其他没有标注数字的格子状态的reward都是零。

-

Set of states

Agent 当前所处的状态集合,就是棋盘上所有的方格,每个方格代表一个状态

-

Set of actions

Agent 可以进行的动作集合,对Gridworld的机器人来说,就是上下左右四个移动方向,所以集合

中包含四个元素 -

Transition function

转移方程,也被称作模型(Model),是环境的重要组成部分,表示机器人在状态

下进行动作 之后转移到状态 的概率,注意这个概率并不总是0和1,比如在Gridworld游戏中,如果由于路面比较滑,机器人明明想要向上移动一格,但是最终向右移动了,这种情况也是可能存在的。我们在确定环境的时候就需要对这些给出定义,例如可以定义机器人成功移动到期望方向的概率是0.8,但是向左和向右移动的概率各是0.1,这就确定了转移方程。 -

Reward function

奖励方程,指的是机器人从状态

进行动作 移动到状态 的动作进行完(离开状态s),环境给出的奖励 -

Start state

初始状态

-

Discount factor

折扣因子,举个例子来说明一下。Agent在进行决策的时候不能仅仅考虑眼前立刻就能获得的reward,也需要考虑进行决策转移到新的state之后下一步决策以及更往后的一系列决策能获得的reward如何,这就是所谓的长远考虑。但是考虑到很多步以后获得的奖励和现在一步就能获得的奖励重要性不同,我们在计算的时候给以后获得的reward的项乘上

的系数,获得这个奖励的状态与当前状态差多少个单位时间,系数就是 的多少次方。 -

Horizon

最大移动的步数

在这个游戏中,我们希望学的的策略

目标已经清楚了,达成这个目标有两个主要途径,这两个途径都是之后强化学习发展的重要基石,分别是价值迭代(value iteration)和策略迭代(policy iteration)

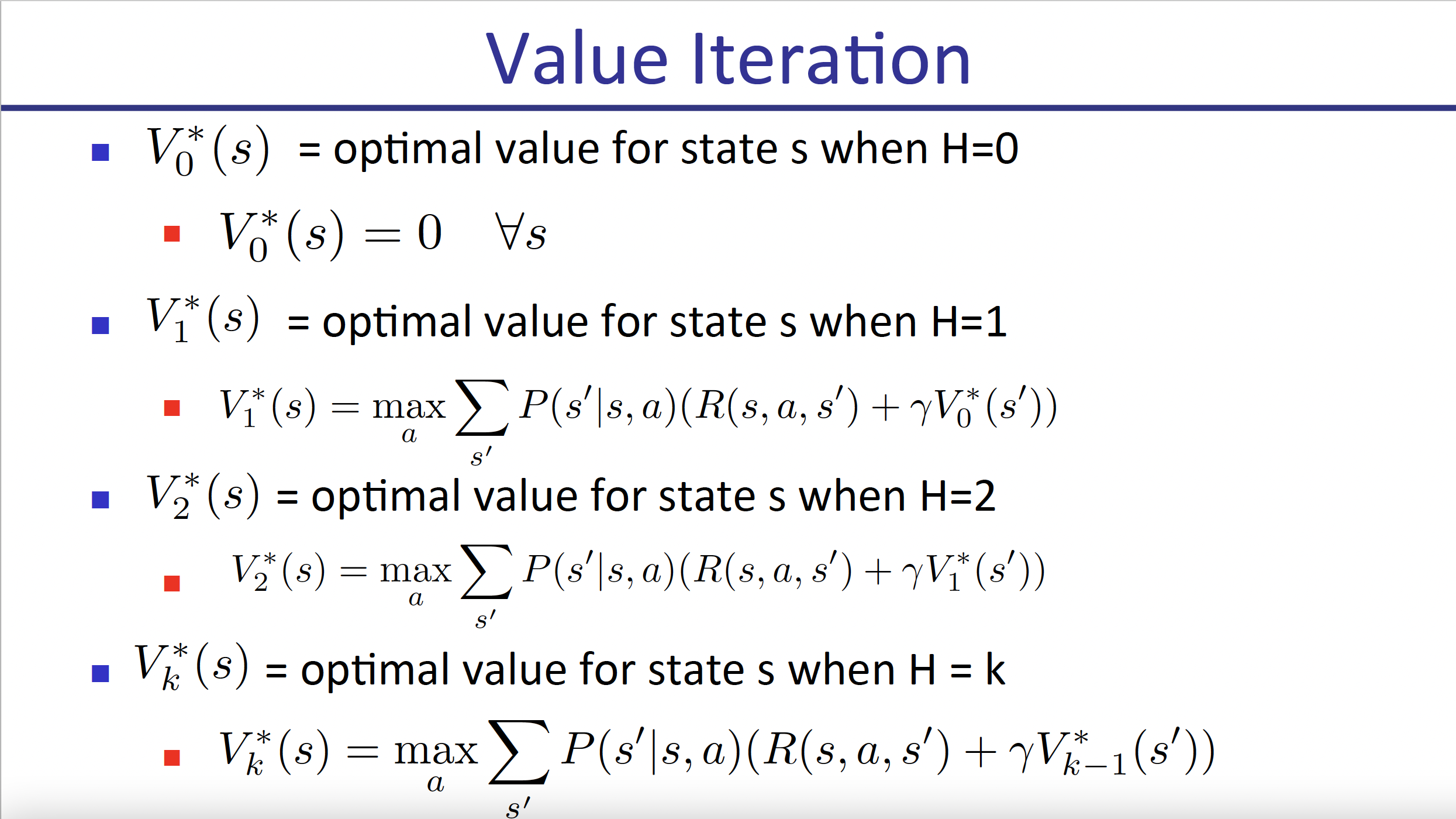

二、价值迭代

1.

价值函数迭代

我们的目标是获得一个最优的价值函数

价值迭代试图用动态规划的思路求得这一最优价值函数,动态规划的思路如下:

也就是(1)首先定义函数

其中转移概率函数和此

上式被称作Bellman Equation,是一个非常著名的等式。综上所述,通过这种方式,我们就可以获得最优价值函数

这里补充一点,正是由于折扣因子

2.

Q函数指的是

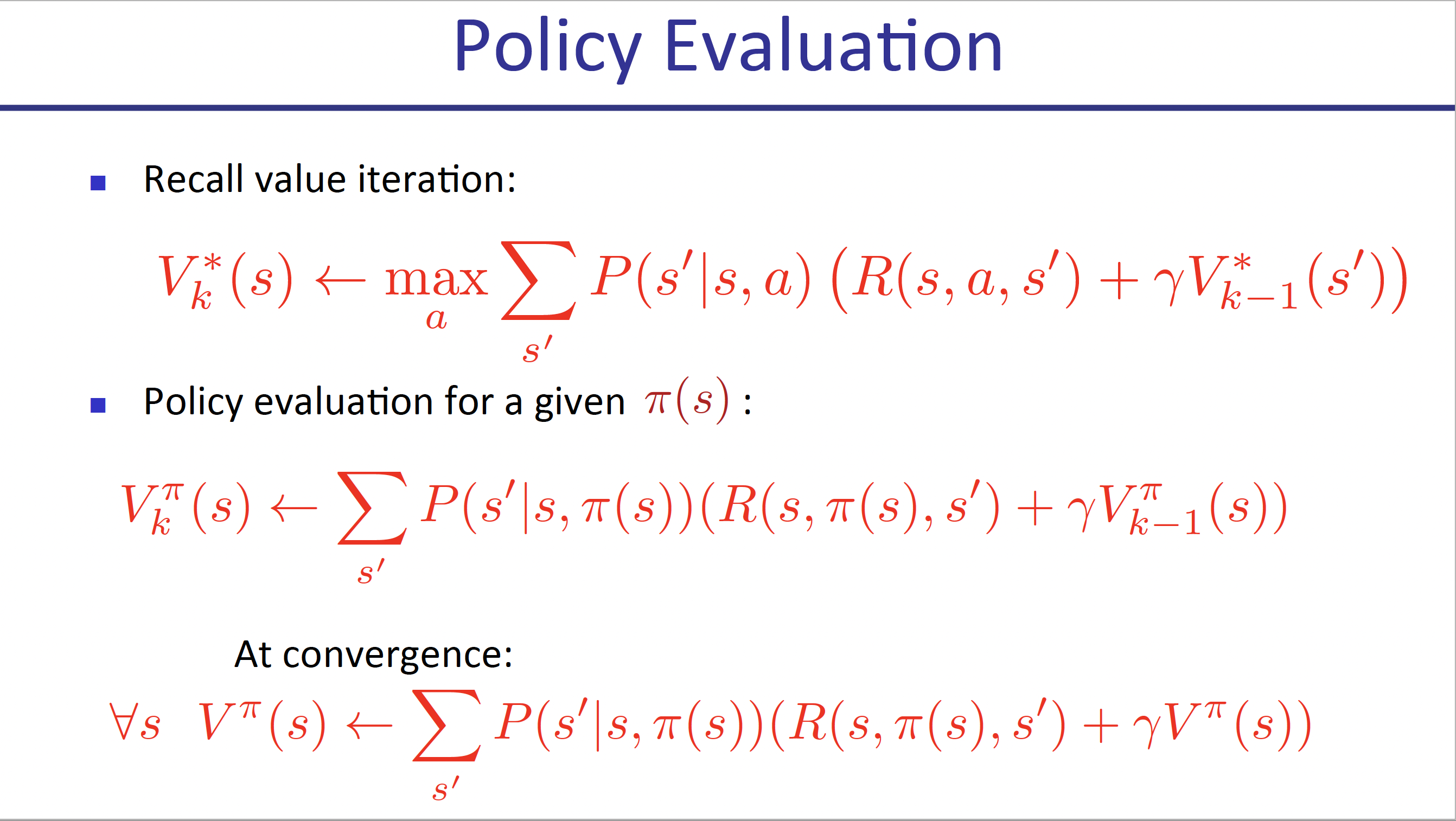

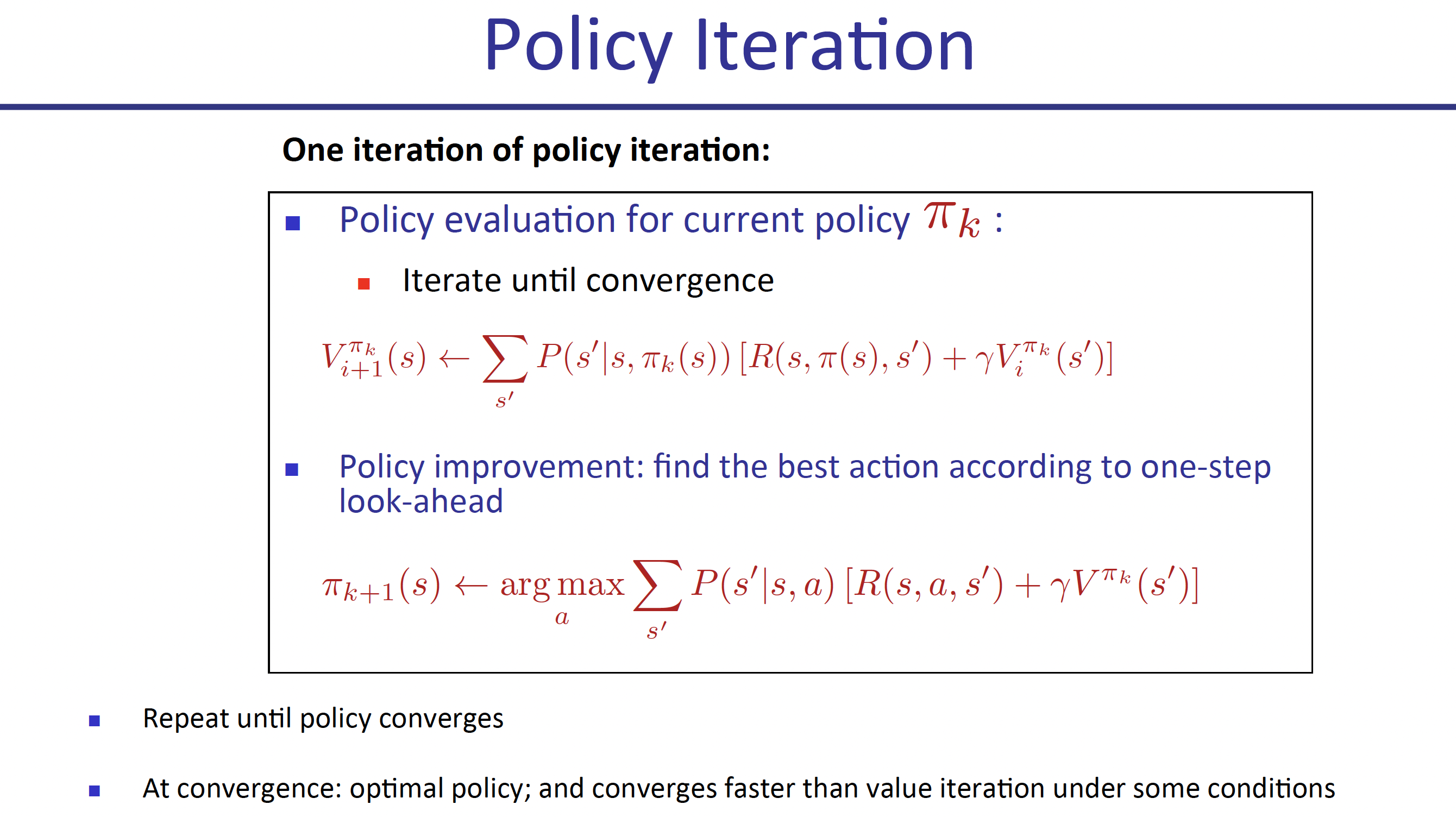

二、策略迭代

回忆

需要注意的是,在进行策略调整的时候,所使用的价值函数是旧策略对应的价值函数

三、总结

以上介绍了MDP的定义,以及使用value Iteration与policy iteration两种简单方法完成了确定有限状态下的强化学习。

主要有两个重大缺陷:

- 价值函数需要存储所有的状态和动作的价值信息,需要状态-动作空间离散并且需要占用大量存储空间,当状态-动作空间维数较高的时候难以完成

- 需要知道转移概率方程,也就需要知道模型才能完成,但是这个条件往往无法得到满足